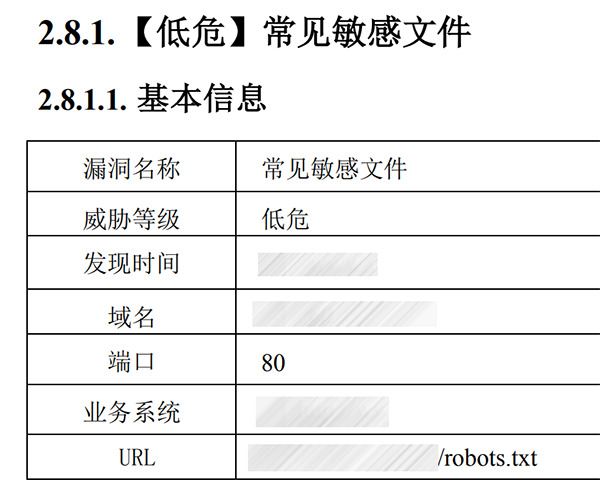

robots.txt 是告诉搜索引擎,你该不该爬,你该爬哪些、不该爬哪些。

这个文件肯定是能够在互联网上被访问到的。

但是某公司,自认为自己是世界标准缔造者,说这是敏感文件泄露。

首先我明确一点,这个 robots.txt 除了不让它们公司的搜索引擎来爬这一配置,没有任何隐私泄露。

但它居然还是提“整改建议”,说:

建议对敏感文件设置访问权限或者删除敏感文件。

小伙子,我设置访问权限,搜索引擎如何来爬?删除敏感文件,搜索引擎如何来爬?

我想问问你读书时是怎么读的?

谁给你们权限定义“高危、中危、低危”的?在你们脑子里,就没有“提示”这一级别吗?